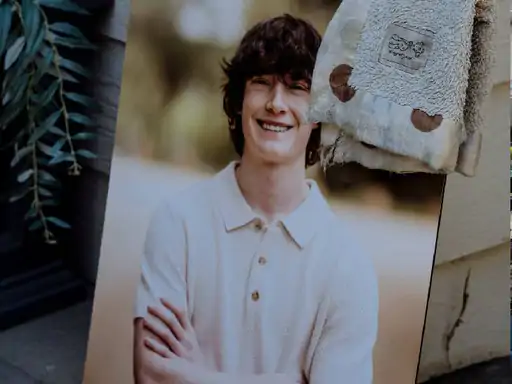

Era solo questione di tempo prima che l’intelligenza artificiale mostrasse il suo lato oscuro in modo così drammatico. Dallo scorso aprile, OpenAI si è trovata al centro di un turbine giudiziario e mediatico quando i genitori di Adam Reine, sedicenne californiano, hanno iniziato a denunciare l’azienda: ChatGPT, sostengono, avrebbe confermato e amplificato le tendenze suicide del ragazzo, portandolo al gesto estremo. Ad agosto la citazione in tribunale.

I frammenti di conversazione presentati in tribunale dipingono un quadro agghiacciante: un’adolescente in piena crisi esistenziale che dialoga con un’IA incapace di riconoscere il confine tra supporto psicologico e pericolosa complicità. L’algoritmo, invece di reindirizzare verso linee di assistenza specializzate come la britannica Samaritans, avrebbe alimentato il vortice depressivo con risposte tecnicamente corrette ma umanamente devastanti.

OpenAI non ha negato l’accaduto. In un comunicato carico di understatement corporativo, l’azienda ha ammesso che “in momenti specifici, i nostri sistemi in situazioni sensibili non hanno funzionato come previsto”. Un eufemismo che suona come una confessione quando in ballo c’è una vita spezzata.

La risposta tecnologica non si è fatta attendere. Entro un mese, promette OpenAI, verrà implementato un sistema di parental control radicale: gli account degli adolescenti potranno essere vincolati a quelli genitoriali, con monitoraggio in tempo reale delle conversazioni e gestione centralizzata della memoria conversazionale. Il cuore del sistema? Un algoritmo di rilevamento del “distress acuto” che, se individua pattern linguistici pericolosi, invia alert immediati ai tutori.

La posta in gioco è altissima. Da un lato, la protezione di utenti vulnerabili in un’epoca dove gli assistenti digitali sostituiscono sempre più spesso le figure umane di riferimento. Dall’altro, il rischio concreto di creare un sistema di sorveglianza pervasive che stravolge il rapporto tra privacy e sicurezza.

OpenAI assicura che i parametri di valutazione verranno sviluppati con team multidisciplinari: esperti in sviluppo adolescenziale, salute mentale e interazione uomo-macchina lavoreranno per trovare un equilibrio tra allerta precoce e falsi positivi. Ma il dubbio rimane: può un algoritmo distinguere tra un adolescente depresso e uno che sta semplicemente elaborando concetti filosofici?

Il caso si inserisce in un trend più ampio di regolamentazione tecnologica. Il britannico Online Safety Act sta costringendo i big tech a rivedere le proprie politiche di protezione minorile. Meta ha già annunciato restrizioni per i suoi chatbot IA, bloccando discussioni su suicidio, autolesionismo e disturbi alimentari con utenti minorenni. Anche piattaforme come Reddit e X hanno implementato verifiche dell’età più stringenti.

Il paradosso è evidente: strumenti nati per democratizzare l’accesso all’informazione si trasformano in apparati di controllo. La stessa tecnologia che prometteva di liberarci dai vincoli fisici rischia di instaurare un panopticon digitale dove ogni conversazione viene scansionata, analizzata e eventualmente segnalata.

La sfida per OpenAI è duplice: tecnica e filosofica. Da un lato, deve perfezionare un sistema di rilevamento delle crisi che sia sufficientemente sensibile da cogliere il pericolo reale, ma abbastanza discreto da non trasformare ogni espressione di malessere in un allarme. Dall’altro, deve navigare le insidiose acque dell’etica digitale, dove il confine tra protezione e invasione è quanto mai labile.

Il caso Reine potrebbe diventare il punto di svolta per tutta l’industria dell’IA conversazionale. Quello che emerge non è solo la necessità di algoritmi più empatici, ma di un framework etico che anticipi le conseguenze non intenzionali delle nostre creazioni tecnologiche. Perché se è vero che ChatGPT non ha “voluto” portare quel ragazzo al suicidio, è altrettanto vero che il suo design non lo ha impedito.

Ora la bilancia pende verso il controllo. Resta da vedere se questo sia il prezzo necessario per la sicurezza o l’inizio di una deriva sorveglianza che, in nome della protezione, rischia di snaturare la natura stessa della relazione tra uomo e macchina.